Comience con una auditoría práctica de la configuración: mapee cada dispositivo, sus datos y quién los utiliza. Esto tema revelan una mayor complejidad en varios sistemas y le ayuda a decidir qué cambiar ahora. Cuando identifica si los dispositivos incluyen teléfonos, sensores o máquinas, puede planificar capacidades y seguridad con confianza.

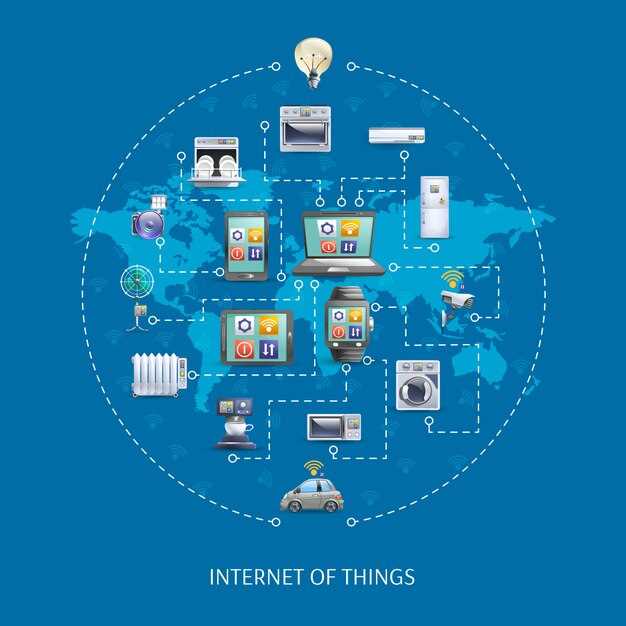

El IoT no surgió ayer. Las semillas comenzaron con sensores simples y medidores remotos en la década de 1980. Las redes inalámbricas y los servicios en la nube luego agregaron conectividad. El término Internet de las cosas ganó fuerza a finales de la década de 1990, y desde entonces, la adición de sensores y actuadores en fábricas, hogares y dispositivos portátiles creó un multicapa un ecosistema con varios niveles de complejidad. Esta evolución incluyó dispositivos como teléfonos junto con sensores dedicados, lo que impulsó a los proveedores a ofrecer soluciones tanto para dispositivos independientes como para implementaciones más amplias.

Moldee la resiliencia con un plan de seguridad multicapa en los niveles de dispositivo, red y nube. Una configuración mínima práctica incluye el arranque seguro, las actualizaciones firmadas y la autenticación de dos factores para el acceso de administrador. No puedes depender únicamente del firmware; combina el análisis automático de vulnerabilidades con controles de acceso estrictos, datos cifrados en tránsito y redes segmentadas para limitar el radio de explosión. El plan consiste en exigir actualizaciones continuas y estar preparado para adaptarse a medida que evolucionan las amenazas.

De cara al futuro, establezca una incorporación repetible para los nuevos dispositivos mediante el uso de interfaces estándar y rutas de actualización verificadas. Elija arquitecturas escalables con sistemas modulares e interoperables. soluciones, y establecer un cronograma claro para agregar dispositivos en todas las oficinas o instalaciones. Realice un seguimiento de métricas como el tiempo de incorporación, el tiempo medio de aplicación de parches y la latencia de datos para justificar las inversiones, y planifique la adición de nuevos teléfonos o sensores en equipos paralelos sin interrupciones. Si no está seguro, no espere para comenzar con un piloto pequeño y enfocado.

Desde las primeras aplicaciones hasta los ecosistemas integrados: trazando la evolución del IoT

Comience con una recomendación concreta: inventaríe cada dispositivo y marque sus funciones como nodos, luego seleccione un único nombre arquitectónico y definiciones de datos estándar para guiar la integración.

La analogía ayuda a vincular implementaciones anteriores con los ecosistemas actuales. En la década de 2000, sensores simples en electrodomésticos o dispositivos portátiles recopilaban datos que se trasladaban a un concentrador a través de una puerta de enlace, formando una arquitectura temprana que recompensaba la modularidad y el procesamiento local.

Ese poder proviene de la capacidad de extender la vida útil de los dispositivos a través de actualizaciones inteligentes inalámbricas y de abrir la puerta a nuevos servicios sin reescrituras disruptivas.

A medida que los ecosistemas maduraban, las plataformas ofrecían interfaces específicas, creando exclusividad pero también impulsando la interoperabilidad cuando se respaldaban con estándares abiertos. Por encima de todo, las partes interesadas tendían a favorecer arquitecturas escalables que conectaran vehículos, sensores portátiles y dispositivos industriales a través de protocolos comunes.

Las definiciones cambiaron a medida que las redes pasaron de máquinas aisladas a sistemas coordinados y distribuidos. Los modelos anteriores hacían hincapié en la recopilación de datos brutos, mientras que las pilas modernas hacen hincapié en la computación perimetral, la comunicación segura y la interpretación de señales entre dispositivos.

Las previsiones optimistas apuntan a una mayor privacidad, tiempos de respuesta más rápidos y mejores presupuestos de energía en el extremo. Tal vez las organizaciones deberían poner a prueba casos de uso intersectoriales (atención sanitaria, fabricación y movilidad) utilizando una ontología compartida para reducir la fragmentación, un paso que nos acerca a ecosistemas más coherentes.

La historia depende de una interpretación clara de roles: los dispositivos se convierten en agentes capaces, las plataformas proporcionan puntos de acceso y los desarrolladores pueden reutilizar componentes a lo largo de los ciclos de vida en lugar de reconstruir desde cero. Dicho por líderes de la industria que impulsan la interoperabilidad, el mensaje es que una arquitectura creíble reduce el encierro forzado y, a la vez, apoya la innovación.

En la práctica, los equipos deberían mapear la gobernanza: quién posee los datos, cómo se actualizan los dispositivos y cómo se protege la privacidad; este enfoque se centra en una definición práctica de los procesos y en un ecosistema viable mínimo que pueda escalarse a través de los sectores.

Con una visión de futuro, la trayectoria del IoT se desplaza desde dispositivos aislados hasta ecosistemas integrados que se coordinan mediante estándares comunes, lo que permite nuevos flujos de valor a un menor coste por nodo.

¿Cómo funcionaban las primeras conexiones M2M con ancho de banda y energía limitados?

Informar solo sobre cambios significativos: establecer un umbral basado en datos para transmitir cuando los valores crucen un pequeño delta, empaquetar datos en tramas binarias compactas y almacenar datos localmente de forma provisional cuando el canal esté inactivo. Este cuidado por la energía y la vida produce menos mensajes, pero más valiosos, que viajan a través de un ancho de banda limitado.

Estas decisiones de diseño reflejan las limitaciones de las primeras redes. Un solo medidor o sensor a menudo tenía una disponibilidad de enlace limitada, compartiendo una escasa interfaz aérea como SMS o un estrecho canal de RF. Condiciones como señal débil, límites de energía y ciclos de trabajo ajustados obligaron a los ingenieros a mantener las operaciones simples, fiables y predecibles, creando una base de trabajo donde los datos podían entregarse incluso cuando la vida pendía de una conexión limitada. El almacenamiento en búfer local y la lógica de reintento permitieron que los dispositivos involucrados en una red siguieran siendo útiles sin contacto constante.

Las cargas de datos permanecieron pequeñas: 40–160 bytes por mensaje eran comunes, con 0–4 lecturas por transmisión y un CRC básico para la detección de errores. La codificación binaria reemplazó a ASCII para reducir el tamaño; la codificación delta recortó la repetición en series temporales. Cada mensaje incluía una marca de tiempo, un identificador de dispositivo único y un indicador de nivel simple. Para un solo dispositivo involucrado en una red, la fiabilidad por encima de la latencia se convirtió en el criterio; un lote que llega una vez cada pocos minutos suele ser suficiente para la lectura de contadores o las comprobaciones de estado, lo que mantiene el nivel de actividad mínimo y predecible.

El ahorro de energía se basaba en el ciclo de trabajo: las radios dormían entre ráfagas y los microcontroladores se detenían entre tareas. La corriente media se mantenía en el rango de los miliamperios; las reactivaciones se producían únicamente para las transmisiones. En muchas implementaciones, una batería de unos pocos amperios-hora podía durar varios años; por ejemplo, un contador doméstico que transmitía una vez por hora utilizaba un promedio de 1-5 mA, dependiendo de la tecnología de radio, el ciclo de trabajo y el tamaño del mensaje. Provisionalmente, los dispositivos utilizaban una sencilla red eléctrica o una energía solar de reserva para hacer frente a las largas interrupciones, manteniendo una vida útil coherente basada en datos. Estos patrones se convierten en una base evolutiva para las LPWAN modernas.

Las primeras redes favorecían protocolos sencillos: un canal, tramas pequeñas y mínimos handshakes. La creciente necesidad de gestión integrada dio lugar a informes de estado con un solo mensaje por evento. Un enfoque sólido utilizado por muchos proveedores incluía ack/nack y reintento dentro de una ventana fija; si un mensaje fallaba, se realizaría un intento posterior cuando las condiciones de la señal mejoraran. Esta estrategia mantiene a los dispositivos involucrados, pero no sobrecargados, protegiendo la vida útil de la batería y, al mismo tiempo, admitiendo operaciones basadas en datos.

En un sentido más amplio, estas restricciones crearon dispositivos que se integran en la vida cotidiana con poca supervisión humana. Fueron aprovisionados provisionalmente e integrados en sistemas más grandes y compatibles, a menudo con la capacidad de reconfigurarse de forma remota de manera segura y priorizando la funcionalidad sin conexión. Para usos personales o comerciales, ese enfoque redujo los gastos generales de mantenimiento al tiempo que garantizaba que los datos críticos lleguen al centro de control en condiciones difíciles.

A continuación, se presentan conclusiones prácticas para los profesionales de hoy: adoptar una mentalidad basada en datos, mantener los mensajes pequeños, alinear la frecuencia de transmisión con los requisitos de vida de la aplicación y realizar pruebas en condiciones ocultas, como movimiento o interferencia. El arco evolutivo muestra cómo las transmisiones simples y únicas se convierten en parte de una arquitectura integrada y resiliente que apoya vidas y cuidados con una energía mínima. La pregunta sigue siendo: ¿qué combinación de umbral, codificación y estrategia de suspensión se adapta mejor a su caso de uso? La respuesta radica en equilibrar la fiabilidad, la latencia y la potencia dentro de las limitaciones establecidas.

¿Qué estándares y protocolos permiten la interoperabilidad entre diferentes proveedores?

Adopte Matter como ancla para la interoperabilidad entre proveedores y combínelo con MQTT para flujos de datos y CoAP para dispositivos limitados. Utilice TLS para una incorporación segura y autenticación mutua para reducir costes y riesgos. Con gateways y perfiles de dispositivos estandarizados, permite configuraciones automatizadas plug-and-play que eliminan la configuración manual. Esto evita una generación de dispositivos que solo hablan su propio dialecto y mantiene el mercado en movimiento.

Los estándares y protocolos clave permiten la interoperabilidad: Matter define una capa de aplicación universal para dispositivos IP; Thread proporciona una malla IPv6 de bajo consumo; MQTT y CoAP gestionan el transporte de datos para diversos ecosistemas. Bajo presión presupuestaria y con hardware limitado, los equipos confían en implementaciones ligeras y una certificación robusta para evitar la fragmentación. Zigbee y Z-Wave pueden conectarse a Matter a través de gateways, mientras que TLS asegura el registro y las actualizaciones de firmware de forma inalámbrica.

Las primeras implementaciones se beneficiaron de la inscripción automatizada, los perfiles de dispositivos estandarizados y un enfoque en las condiciones para una operación confiable. Si bien la seguridad importa, estas soluciones también simplifican la gestión al mantener las configuraciones bajo un marco común. Este enfoque aborda preguntas sobre el ciclo de vida, el soporte y las cadencias de actualización. Las pasarelas convierten pilas dispares en un sistema interconectado coherente, y los dispositivos equipados con hardware Matter pueden unirse a un ecosistema compartido sin ajustes manuales.

Los estándares de gestión como OMA LwM2M y los perfiles guiados por IPSO proporcionan una gestión, aprovisionamiento y telemetría de dispositivos consistentes. Aunque algunas implementaciones siguen estando centradas en la nube, muchas dependen del procesamiento en el borde y de las actualizaciones OTA automatizadas para reducir de nuevo los fallos.

Los resultados del cliente mejoran cuando los estándares unifican un amplio mercado de productos compatibles, reduciendo los costos y ampliando las opciones. Las empresas que invierten en gobernanza abierta, pruebas de interoperabilidad periódicas y cadencias de actualización predecibles reducen los errores y impulsan una adopción más rápida. Al tratar las pasarelas como puentes lógicos en lugar de adaptadores permanentes, los equipos pueden escalar las soluciones en diferentes entornos a lo largo del tiempo, manteniendo la seguridad y la fiabilidad.

¿Dónde se deben procesar los datos: en el borde, la niebla o la nube en implementaciones reales?

Procese datos críticos para la latencia en el borde; descargue la agregación más amplia a la niebla; reserve la nube para el entrenamiento y la gobernanza.

Edge permite edificios, sistemas automotrices y entornos más inteligentes al mantener los datos cerca de la fuente. Los dispositivos Edge, impulsados por procesadores de nivel semiconductor, operan con presupuestos de energía ajustados y se basan en enclaves seguros para proteger los datos confidenciales. Esta proximidad produce respuestas de menos de 20 ms para luces, controles de acceso y fusión de sensores, al tiempo que reduce el tráfico de la red y preserva las capacidades fuera de línea cuando la conectividad es limitada. Ese recorrido desde el sensor hasta la acción es lo que hace que las decisiones de Edge sean tan efectivas, y para las aplicaciones orientadas al cliente en teléfonos y terminales in situ, las decisiones de Edge ofrecen retroalimentación inmediata y una visión coherente del usuario.

La niebla se sitúa entre el borde y la nube, añadiendo una capa regional que agrega datos de múltiples puntos finales. Promueve una visión local de las operaciones a través de un campus, un parque de vehículos o una manzana, permitiendo el preprocesamiento, el análisis que preserva la privacidad y la aplicación de políticas que escalan más allá de un solo dispositivo. Al mantener los datos más cerca del borde, la niebla reduce la salida de la nube en un margen significativo y mantiene una coordinación de baja latencia para entornos de múltiples dispositivos. Si escucha preocupaciones sobre la latencia o la soberanía de los datos, ese es un caso de uso principal para la niebla, ya que puede editar modelos y distribuir actualizaciones rápidamente entre los dispositivos sin centralizar todo en la nube. Este enfoque de tres niveles sigue siendo válido en todas las industrias.

La nube gestiona el almacenamiento a largo plazo, el análisis exhaustivo y la gestión multisistema. Impulsa perspectivas transformadoras a partir de datos agregados, entrena modelos con diversas entradas de miles de dispositivos y proporciona la exclusividad de la seguridad y la auditabilidad centralizadas. La perspectiva de la nube permite la planificación estratégica, la optimización de flotas de automóviles y la elaboración de informes para toda la empresa, al tiempo que añade una escalabilidad que sería inviable en el perímetro o la niebla informática por sí solos. Este equilibrio también respalda la evolución de la tecnología y los modelos de negocio cambiantes. Para los servicios de atención al cliente, la nube ofrece una visión única y fiable de las operaciones en todas las ubicaciones. Dado que los volúmenes de datos crecen con el tiempo, la nube sigue siendo el mejor lugar para el archivo, la evaluación comparativa histórica y la coordinación global, especialmente cuando se necesita comparar diferentes regiones, ejecutar simulaciones o compartir información con los clientes a través de paneles de control. Priorizar la nube para las cargas de trabajo no latentes tiene sentido, pero funciona mejor cuando las estrategias de perímetro y niebla informática impulsan la carga de trabajo en tiempo real.

¿Cómo pasaron los arquitectos de las aplicaciones independientes a los sistemas integrales de IoT?

Adopte una estrategia basada en una plataforma que unifique los datos, el comportamiento de los dispositivos y los flujos de trabajo desde el sensor hasta el servicio, en lugar de parchear aplicaciones independientes. Esto significará menos dolores de cabeza en la integración y una única fuente de información veraz en el borde, la puerta de enlace y la nube. Tal vez este enfoque también acelere la entrega al alinear a los equipos en torno a un modelo común.

En el camino, los arquitectos descubrieron que pasar de una visión centrada en las cosas a sistemas de extremo a extremo requiere integrar computación en el borde y estandarizar los flujos de datos subyacentes. No requiere eliminar las aplicaciones heredadas de la noche a la mañana, se puede migrar gradualmente con adaptadores, proyectos piloto y refactorizaciones incrementales. Esto crea una gran base para análisis escalables y controles listos para la privacidad que siempre respetan el consentimiento del usuario.

En una planta procesadora de leche, sensores integrados monitorean la temperatura, la viscosidad y el flujo. El dispositivo se comunica a través de una red en línea robusta, y los datos se procesan localmente en la máquina antes de enviar métricas agregadas a la nube. Esta configuración reduce la latencia, aumenta la trazabilidad y respalda la presentación de informes conformes entre lotes.

- Estandarizar una estructura de datos común en cada cosa, gateways de perímetro y servicios en la nube, garantizando que la semántica subyacente sea coherente y fácil de entender.

- Traslade la inteligencia al borde y conecte los dispositivos a través de un backend escalable, utilizando protocolos ligeros (MQTT/CoAP) y un sólido soporte offline para mantener el funcionamiento cuando la conectividad online sea intermitente.

- Automatice el ciclo de vida de dispositivos y servicios, incluyendo el aprovisionamiento, las actualizaciones inalámbricas de firmware, la telemetría y la reversión segura, para acortar los ciclos de implementación sin transferencias manuales.

- Establecer una gobernanza con un alcance claro, minimización de datos y acceso basado en roles para proteger la privacidad al tiempo que se habilitan análisis legítimos en todos los procesos y equipos.

- Mida el impacto con métricas concretas para cada capa: latencia, fiabilidad, uso de energía y calidad de los datos, y utilice esa retroalimentación para iterar en toda la pila.

- Organizar equipos multidisciplinarios en torno a estándares compartidos, creando una vía rápida desde el concepto hasta la entrega y asegurando una clara propiedad tanto para los componentes de hardware como de software.

El cambio ofrece un conjunto de capacidades transformadoras que combina inteligencia integrada con flujos de trabajo automatizados, lo que respalda operaciones siempre activas y una experiencia coherente en línea/fuera de línea. Al unificar los datos a nivel de objeto en una plataforma integrada, los arquitectos permiten una mayor resiliencia, privacidad desde el diseño y una rápida adaptación a los requisitos cambiantes en todas las industrias.

¿Cuándo maduró el IoT industrial de las pruebas piloto al uso generalizado en la producción?

Escale el IIoT ahora pasando de proyectos piloto a sistemas integrados y listos para producción que conectan sensores en el borde con análisis en la nube e interfaces estandarizadas. Construya un modelo de datos único y compartido e instale paneles de control fáciles de usar para reducir el tiempo de obtención de valor en todos los sitios.

En la década de 2010, los pilotos demostraron el valor en líneas controladas; año tras año, muchos sitios replicaron estas configuraciones. El punto de inflexión se produjo alrededor de 2017–2019 cuando la adición de dispositivos perimetrales, una conectividad a Internet más fiable y componentes semiconductores rentables permitieron implementaciones de producción generalizadas. Las empresas de telecomunicaciones intervinieron con redes IIoT dedicadas, ayudando a las plantas a conectarse a los sistemas empresariales. El cambio dominante no fue solo la tecnología, sino un ecosistema que proporciona datos compartidos en los lugares donde se realizan las operaciones, integrando sensores, pasarelas y análisis en una visión cohesiva.

En pocas palabras, el cambio se reduce a una mayor disponibilidad de datos, decisiones más rápidas y una colaboración intersitios más sencilla. Los fallos enseñaron duras lecciones, y esas lecciones agudizaron la forma en que diseñamos para la fiabilidad. Comience con 3–5 casos de uso de alto valor, luego escale; elija una plataforma que ofrezca análisis integrados, API robustas y un intercambio de datos seguro. La gobernanza de los datos debe definirse dentro del ámbito de la gestión de la planta, con una clara propiedad y controles de acceso. Este enfoque reduce el riesgo y acelera la adopción por parte del usuario, al tiempo que mantiene los costes predecibles.

La implementación de IIoT en múltiples sitios se beneficia de pasos concretos: estandarizar interfaces, alinear modelos de datos y capacitar a los equipos para interpretar alertas en tiempo real. Un camino práctico combina la integración back-office con la visibilidad a pie de planta, de modo que los equipos de operaciones vean realmente mejoras medibles en el tiempo de actividad y la producción.

| Factor | Acción | Impacto |

|---|---|---|

| Integración del extremo a la nube | Adopte una plataforma integrada con sensores, pasarelas y análisis; imponga interfaces estandarizadas y un modelo de datos compartido. | Valor más rápido, datos consistentes entre sitios; gobernanza más sencilla. |

| Data governance | Definir el ámbito de competencia, la propiedad de los datos y la seguridad; establecer políticas para el intercambio de datos. | Menor riesgo y mayor confianza para compartir datos con socios. |

| Conectividad | Aproveche las telecomunicaciones o las redes administradas para escalar la comunicación confiable a todos los activos. | Mayor tiempo de actividad; incorporación más rápida en todas las plantas. |

| Estrategia de casos de uso | Seleccione entre 3 y 5 casos de uso de alto valor; itere y amplíe en función del éxito. | Mejor retorno de la inversión; reducción de fallos en los proyectos. |

| Personas y procesos | Capacitar a los equipos, coordinar con las operaciones y establecer KPIs medibles (OEE, MTTR). | Adopción sostenible y justificaciones claras. |

IoT Is Not New – A Brief History of Connected Devices">

IoT Is Not New – A Brief History of Connected Devices">