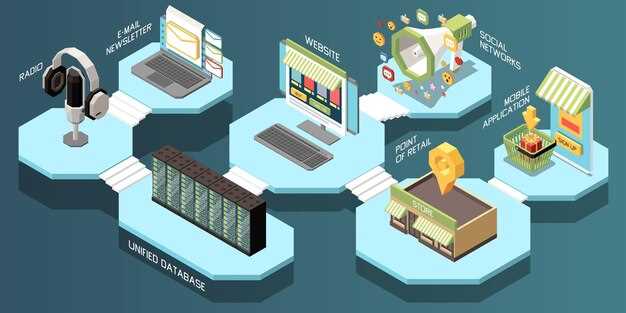

Begin with a concise two‑phase pilot to validate feasibility of distributed ledger tech within provenance networks; Phase one targets 6–8 suppliers, 2 manufacturers, 1 retailer, 1 logistics partner; phase two expands to 15–20 participants. Track data quality, event latency, recall response times; use a secure exchange tool with standard interfaces to minimize changes to existing systems. This concrete plan limits risk; it shows measurable gains in speed, transparency, integrity.

Practical applications include provenance visibility; supplier onboarding; batch traceability; recall readiness. monitoring data quality yields actionable insights. A secure exchange tool aligns with existing platforms; this enables communication across companies; personnel can react faster. infrastructure scales from edge nodes to cloud servers; the meyliana reference shows how known ecosystems behave in real conditions. Google-style analytics support evaluation of performance, especially during volatility. Relationships among companies, platforms, suppliers; secure relationships.

Feasibility findings shape infrastructure investments; staged rollouts yield early wins. A rapide feedback loop relies on a lightweight fonctionnalité set; robust monitoring provides ongoing evaluation. Staff training matters for secure workflows; clear documentation supports cross‑company communication. Relationships with known platforms, suppliers; customers strengthen resilience.

Directions for study include interoperability standards, risk modeling, regulatory alignment; pilot results publish ROI metrics such as recall time reductions, data accuracy improvements. Google dashboards provide ongoing evaluation of cost efficiency; the same approach scales across platforms; diverse markets. A modular infrastructure supports rapid expansion from regional networks to global ecosystems; a lightweight helo protocol sustains reliable data exchanges. meyliana-style scenarios illustrate practical frictions; staff training, relationships management across known participants gains momentum.

Implementing Provenance and Real-Time Data Integrity in Track-and-Trace Workflows

Recommendation: Deploy a hybrid provenance engine binding each data point at capture to a tamper-evident hash; implement real-time data integrity checks on every event; publish auditable summaries to public dashboards; this design reduces lack of visibility, raises throughput; yields cleaner trust across buyers, platforms; intermediators; produced data points logged at source are traceable to their origin; shen, khan, kaldoudi, cole cited a positive impact in field pilots; transformed risk landscape remains credible; public authorities review results.

Implementation blueprint

In practice, begin with edge captures at facilities handling food; attach a cryptographic seal to each record; synchronize time with a reliable clock source; each record carries a source fingerprint; examined by automated validators at gateway nodes; if a mismatch occurs, a real-time alert halts downstream selling until verification completes.

Sections within the platform map to stages: receiving; transformation; packaging; distribution; each section stores local hashes; forwards a compact pointer to a public ledger replica; buyers subscribe to feeds for items of interest; platforms offer filters by product type (food; fashion), lot, subject; security controls restricted to personnel with verified roles; drivers include decision-making tools enabling recall actions.

Use-case mapping covers sectors: food; pharma for patients; fashion; each sector uses identical provenance discipline; for pharma, additional constraints protect patients; audits verify provenance across suppliers; intermediators; public risk signals trigger alerts.

Design considerations

Security policy relies on granular access control; risk management aligns with regulatory needs; employ three layers: source validation; validators at intermediators; public validators; lower exposure through separation of duties; throughput preserved during recalls; a risk dashboard compares produced data with expected values; this strengthens public confidence; buyers rely on these signals for decision-making.

Conclusion: Provenance plus real-time data integrity become achievable via a pragmatic engine; source verification; public dashboards; khan, shen studies show lower risk of mix-ups; kaldoudi notes improved decision-making in recall scenarios; buyers gain cleaner visibility; platform adoption scales across products such as food, fashion, patients’ care; measured throughput remains high, despite added checks; liveness signals support regulatory reviews.

Smart Contract Playbooks for Inventory Reconciliation and Automatic Replenishment

Recommendation: implement a modular playbook; reconciliation processes tied to automatic replenishment via tokenized events; data stored across distributed nodes; immutable records ensure traceability; accountability is straightforward. Each token carries a purpose: batch identifiers; item-level serials; location details; energy metrics; latency indicators; entire lifecycle details captured in real-time. Leading organizations would pilot with everledger, walmart, airbus; financing flows linked to inventory status improve working capital cycles. The golden rule remains inter-organizational visibility; privacy preserved; people across roles access a safe, auditable ledger via role-based provisioning. Growth in transparency boosts stakeholder confidence; bogucharskov data streams feed item details; shipments tracked from supplier to receiver to finish-goods staging. Safety considerations reduce vulnerability; this approach scales to provider-level ecosystems with automation, monitoring, financing integration. The architecture enables partners to integrate ERP, WMS, financing modules.

Playbook Architecture

The architecture comprises three component layers: reconciliation module; automatic replenishment engine; audit and reporting layer. Tokens represent every item footprint; each token’s purpose defined; stored in immutable databases across nodes; cross-organization integration supported by secure APIs. The model handles inter-organizational workflows; latency targets exceed 200 ms; latency over 250 ms triggers fallback paths. The golden record for each shipment is maintained; bogucharskov data streams feed item details; growth in transparency reduces risks for walmart, everledger, airbus; financing metrics linked to real-time inventory levels improve cash flow. Each module develops clear ownership by provider teams; people across logistics, finance, quality participate without duplicative records. Easy onboarding provided by templated contracts reduces customization effort; components align with privacy rules; safety protocols protect sensitive payloads; vulnerability scans run before each shipment event. The system can integrate ERP; WMS; financing modules.

Conseils de mise en œuvre

Implementation steps: pilot within a mid-size supplier network; map current workflows; define token taxonomy; configure reconciliation rules; connect ERP; connect WMS; link financing modules; implement role-based access; run latency tests; publish performance dashboards. Prioritize resilience; encrypt sensitive data; maintain golden samples for reference; track energy consumption; align financing cycles; validate with real shipments; monitor risks; define contingency paths. Inter-organizational collaboration documented; bogucharskov case studies provide lessons; easy onboarding guides support people; verify with everledger, walmart, airbus partnerships.

ERP and Legacy System Integration: API, Middleware, and Data Mapping in Practice

Recommendation: adopt an API-first strategy; implement middleware orchestration; map data into a canonical model; boost tractability for practitioners across countries; enable on-demand transfer of data; reduce incurred errors; enhance insights; align with the context of distribution networks; supports selling electronics, products across same models; whole lifecycle from warehouse to distribution park; sensors provide transport status for transported goods; this framework forms the original basis for cross-country collaboration; dutta; parssinen highlight practical themes for migration; wise governance reinforces risk controls.

Data Architecture and Mapping

- Modèle de données canonique : définir des champs tels que product_id, product_name, category, quantity, unit_of_measure, location, lot_or_serial, status, timestamp ; mapper les schémas hérités au schéma ERP via des dictionnaires de mapping ; inclure les modèles dans les sources et les destinations ; garantir la traçabilité pour les analyses en aval.

- Correspondance de l'ancien système aux ERP : créer les règles respectives pour la traduction des noms de champs ; la normalisation du type ; l'harmonisation des données de référence ; conserver les valeurs d'origine pour les pistes d'audit ; stocker les résultats de la correspondance dans une base de données dédiée ; maintenir la traçabilité des données.

- Gestion des données maîtres : établir des enregistrements de référence pour les produits, les lieux, les fournisseurs ; désédupliquer les données entre les pays ; prendre en charge la même taxonomie dans différents contextes ; mettre en œuvre la gestion des versions pour refléter l'apparition de nouveaux SKU ; garantir des contrôles de qualité des données.

- Capteurs et télémétrie : intégrer les capteurs d'entrepôt, les traceurs de transport ; transmettre l'état vers l'ERP en temps quasi réel ; traduire les signaux des capteurs en états de transport tels que arrivé, chargé, expédié ; gérer la latence des données pour éviter des décomptes d'inventaire incohérents.

- Sécurité et accès : appliquer des permissions basées sur les rôles ; chiffrer les champs sensibles ; mettre en œuvre une authentification basée sur des jetons ; s'aligner sur les contraintes réglementaires dans les différents marchés.

Manuel d'exploitation

- Contrats d'API : REST ou GraphQL ; documentation OpenAPI ; versionnement strict ; suites de tests ; tests de contrat pour prévenir les modifications cassantes ; ce qui réduit les perturbations en aval.

- Orchestration de middleware : choisir un orchestrateur central par rapport à des modèles chorégraphiques ; concevoir des points d’entrée idempotents ; utiliser des bus de messages pour la fiabilité ; suivre l’état des messages dans un magasin durable.

- Plan de déploiement : déploiements progressifs sur des sites pilotes ; surveiller la maturité ; étendre à l'ensemble des sites de distribution ; allouer le budget ; les ressources ; suivre les coûts engagés ; ROI.

- Mesures et analyses : définir des KPI tels que la latence des données ; le taux d'erreur ; le délai d'exécution ; l'intégrité des données ; fournir des tableaux de bord à la demande ; générer des informations exploitables pour les chefs de produit, les équipes logistiques.

- Partenariat et contexte : établir une collaboration avec les fournisseurs logistiques, les unités commerciales ; mettre en place un forum de gouvernance ; partager les exigences dans le cadre du flux de distribution global ; assurer l'alignement entre les pays.

Scaling Blockchain for Global Logistics: Throughput, Latency, and Off-Chain Solutions

Recommandation : mettre en œuvre une configuration en trois niveaux avec un état de livre principal ; des canaux hors livre ; une vérification périodique vers une racine ; choisir Hyperledger Fabric ou Hyperledger Besu ; configurer pour répondre aux exigences ; activer l'audit sur les principaux itinéraires ; s'aligner sur les normes réglementaires ; commencer par des pilotes Toyoda aux côtés de partenaires de fabrication ; des flux de matériaux initiaux pour valider la traçabilité ; combiner des données provenant de véhicules, fournisseurs ; transporteurs ; procéder avec un rythme soutenu.

Rationale: Pour une mise à l'échelle adaptée aux douanes mondiales, allez au-delà de la validation sur un seul nœud ; exploitez le débit combiné à partir de canaux hors registre ; utilisez des canaux d'état pour les règlements par lots ; les sidechains autorisent l'expérimentation sans affecter le registre principal ; les latences diminuent à moins de 2 secondes en interne à une région ; les règlements transfrontaliers prennent 10 à 20 secondes avec des preuves agrégées ; amélioration de la qualité des données pour la traçabilité ; mettre en œuvre un modèle de données sécurisé conforme aux exigences réglementaires ; adopter des jumeaux numériques standardisés pour le flux de matériaux ; appliquer des propositions pour l'audit des réclamations ; accélérer l'adoption dans des secteurs tels que la fabrication, la santé, les transports ; une gouvernance bien définie favorise la confiance.

Implementation milestones

| Layer | Rôle | Débit cible (TPS) | Cible de latence (s) | Off-ledger Mechanism | Sécurité |

|---|---|---|---|---|---|

| État du grand livre central | Enregistrement autoritaire | 1 000–3 000 | 0,5–2 | Translation not available or invalid. | Audits prêts, hachages cryptographiques |

| Off-ledger channels | Mises à jour rapides | 3 000–10 000 | 0,1–0,5 | Canaux d'état, règlements par lots | Ancré à l'état central, notariat périodique |

| Checkpoint racine | Cross-domain trust anchor | 500–2 000 | 1–3 | Root commitments | Forte PKI, preuves ancrées aux actifs |

Principales propositions

notes succinctes : viser un standard d'or en matière de flux de confiance ; les choix logiciels évolutifs incluent les implémentations Hyperledger ; les premières étapes impliquent une collaboration avec Toyoda et les divisions de fabrication ; l'alignement réglementaire reste essentiel ; les secteurs de la santé bénéficient d'une traçabilité personnalisée des matériaux ; accords entre les transporteurs et les fabricants ; les voies explorées permettent un accès plus rapide au marché ; des sources documentent les progrès ; le rythme correspond aux cycles réglementaires ; les initiatives soutenues par Kennedy traitent des défis liés à la réglementation, à la confidentialité et aux frictions transfrontalières ; les registres d'or soutiennent l'auditabilité ; les relations de travail avec les partenaires accélèrent le déploiement.

Confidentialité, sécurité et conformité dans les transactions transfrontalières de la chaîne d'approvisionnement

Mettre en œuvre des mesures de protection de la vie privée fondées sur l'évaluation des risques par défaut ; déployer un chiffrement de bout en bout, une authentification robuste ; appliquer des contrôles d'audit stricts. Cette posture permet d'obtenir les gains les plus importants en termes de confiance ; les partenaires comprennent les opérateurs de télécommunications, les douanes, les fournisseurs opérant selon des règles communes.

Sous la surface, les mécanismes de traçabilité fournissent des détails sur l'origine des données au-delà des frontières ; la confidentialité par conception, la minimisation des données ; la limitation des finalités alignée sur les architectures approuvées, assurant un traitement équitable des données, permettant la croissance ; les équipes analysent les signaux de risque.

La détection d'anomalies repose sur une surveillance continue des données télémétriques collectées ; les journaux d'audit produisent un enregistrement opérationnel approfondi ; ici, les signaux de risque deviennent exploitables ; une isolation certaine est possible ; une résilience accrue s'ensuit.

Mesures de sécurité opérationnelles

Références de recherche : pankowska ; juma ; notes de papier provenant de nanosci concernant l’énergie ; cryptographie efficace ; les architectures inter-chaînes permettent une meilleure application des politiques ; une protection inégalée ; des recommandations judicieuses émergent ; les jeunes chercheurs fournissent un contexte et des connaissances.

Contexte de gouvernance et de conformité

L'autorité établit des exigences de base; les détails d'implémentation couvrent l'échelle, la formation, ainsi que les flux de travail de réingénierie; ici, les approbations sont émises par l'autorité; pendant que le développement des talents progresse, les modèles de risque arrivent à maturité; cela pourrait réduire les fuites; des contrôles appropriés restent en place pour préserver la confidentialité.

Blockchain in Supply Chain Operations – Applications, Challenges, and Research Opportunities">

Blockchain in Supply Chain Operations – Applications, Challenges, and Research Opportunities">