Iniziare con una base di riferimento definita per i processi chiave; questo allineerà la misurazione al valore del cliente, consentendo un chiaro progresso.

Exabyte di dati guidano le decisioni; andando oltre i sistemi isolati, l'obiettivo è definito, il rischio di fallimento diminuisce, il valore per i clienti aumenta.

Per evitare sprechi, stabilire una baseline per la dimensione dei dati; titolarità della governance, collaborazione interfunzionale, ruoli definiti.

Con il sostegno della dirigenza, tradurre i dati in azioni; questi leader devono allineare budget, priorità e obiettivi.

Per iniziare questo lavoro, assicurarsi che la base di partenza sia accurata; la dimensione dei dati è importante, i risultati per i clienti migliorano quando ciò viene fatto.

Utilizzo Attraverso la mappatura interfunzionale, i team convertono gli insights in azioni misurabili; tali azioni sono importanti per i livelli di servizio, i costi, la resilienza, la soddisfazione del cliente.

Per chi va avanti, definite le metriche di successo, mantenete aggiornata la baseline, evitate la perdita di conoscenza a silos, assicuratevi che il cliente rimanga il punto focale.

Piuttosto che inseguire un'ampia popolarità, questo framework deve essere adottato. together da team operativi, finanziari e commerciali per fornire una definizione tangibile di successo, almeno per una baseline definita.

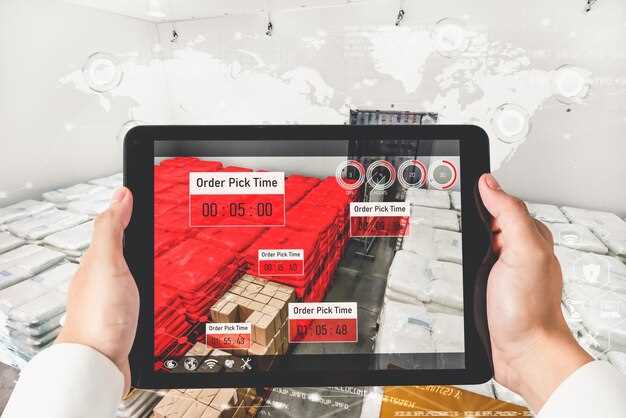

Aggiornamenti Chiave che Guidano la Visibilità della Supply Chain Globale

Raccomandazione: implementare una data fabric unificata che acquisisca feed non strutturati e metriche strutturate da dispositivi, warehouse e operatori per ottenere visibilità in tempo reale. Sebbene la maggior parte delle organizzazioni miri al miglior equilibrio tra velocità e governance, soprattutto è necessario un modello di dati definito che tenga traccia degli eventi tra sessioni e dispositivi per comprendere il comportamento, dove i dati sono importanti e ci sono punti di guasto che possono essere rilevati precocemente, in modo da poter agire.

Sapere dove i segnali non strutturati mappano le metriche è importante e lo stesso framework funziona nella maggior parte dei casi d'uso. Per essere concreti, pianificare gigabyte di telemetria al giorno e configurare la retention definita dalle esigenze aziendali. La governance proposta deve includere la provenienza dei dati, i controlli di accesso e le tracce di audit per prevenire errori dovuti a un'errata interpretazione. Monitorare i progressi attraverso metriche come l'arrivo puntuale dei dati, la latenza degli eventi e la fiducia negli avvisi di anomalia; questo aiuta a rispondere a dove hanno origine i problemi e quale azione è richiesta. Questo approccio è concepito per scalare con flussi di dati in crescita.

Fasi di implementazione

Fasi di implementazione: inizia con una serie definita di eventi principali, mappa a schemi standardizzati e abilita sessioni edge-to-cloud su dispositivi e strutture. Quindi, stabilisci un archivio dati unificato in grado di gestire gigabyte al giorno e fornire query rapide per operatori e pianificatori. Soprattutto, implementa un modello di avviso che segnali precocemente deviazioni nel comportamento e attivi la correzione automatizzata ove possibile. Generalmente, allinea gli accordi di condivisione dei dati tra più parti e assicurati che le regole di qualità dei dati siano applicate per prevenire disallineamenti. Ancora più importante, mantieni un'unica fonte di verità, con una chiara titolarità e definizioni di metriche documentate, in modo che i team possano monitorare i progressi e ridurre le modalità di errore.

Sfruttare i dati in tempo reale per le decisioni sull'inventario

Implementare un loop di dati in tempo reale che aggiorni le posizioni di magazzino ogni 15 minuti tra negozi, CD e canali online, e che regoli automaticamente gli acquisti per le SKU principali. Questo approccio semplice e misurato riduce le rotture di stock e l'inventario in eccesso, accelerando al contempo l'esecuzione.

Stabilire una dorsale leggera che acquisisca dati da POS, WMS, ERP, portali fornitori e segnali IoT in un livello di streaming. Mirare a una latenza inferiore a 15 minuti per gli articoli a rapida rotazione e inferiore a 60 minuti per gli articoli stabili. Sono più affidabili se allineati a un unico modello di dati e a una chiara titolarità, il che consente ai team di operare con sicurezza in tutta l'organizzazione.

Gli input non strutturati provenienti da fornitori, e-mail e note richiedono normalizzazione e tag, con estrazione assistita da NLP per convertire il testo in campi utilizzabili. Crea un ciclo di apprendimento che acquisisca il feedback degli stakeholder e lo traduca in regole concrete memorizzate in un set di regole centralizzato che gli uffici acquisti, pianificazione e operations possono riutilizzare. image source: unsplash

Il patrocinio esecutivo e l'allineamento degli stakeholder tra acquisti, pianificazione, logistica e merchandising sono essenziali. Sono responsabili della definizione delle regole di base, dell'approvazione delle soglie e della garanzia della governance. Utilizzare le stesse dashboard per tutti i destinatari, con visualizzazioni basate sui ruoli che mantengono la visibilità elevata senza sovraccarico.

Passare da decisioni basate sull'intuito a decisioni guidate dai dati avviene attraverso un approccio graduale. Inizia con tre progetti pilota che coprano prodotti a rapida rotazione, articoli stagionali e una categoria di controllo, quindi scala dopo aver raggiunto obiettivi definiti: riduzione delle rotture di stock del 20–40%, miglioramenti del livello di servizio di 5–12 punti e aumento del turnover di 1,2–1,6 volte.

- Cadenza e struttura portante: implementare l'acquisizione in streaming, definire i target di latenza e stabilire avvisi per le violazioni; allineare le definizioni dei dati tra le sedi.

- Qualità dei dati e segnali non strutturati: normalizzare i campi, etichettare gli attributi, applicare l'NLP ai documenti dei fornitori e mantenere un dizionario dati attivo; assegnare i proprietari dei dati (team di stakeholder).

- Regole decisionali e calcoli: utilizzare un insieme di regole trasparente con formule come ROP = tasso_di_domanda × lead_time + z × sigma × sqrt(lead_time); sperimentare le soglie per bilanciare il servizio e i costi di mantenimento.

- Governance e apprendimento: pianificare revisioni trimestrali con dirigenti e team; acquisire lezioni apprese da ogni ciclo; aggiornare di conseguenza regole e soglie.

- Dal progetto pilota all'implementazione su vasta scala: definire i criteri di successo, monitorare gli stessi KPI e documentare gli insegnamenti per l'implementazione in tutte le categorie e i canali.

- Risultati e misurazioni: monitorare i cicli di acquisto, i giorni di copertura, la velocità di rotazione delle scorte e l'impatto sul margine lordo; comunicare ai stakeholder i miglioramenti in corso con visualizzazioni chiare.

Nearshoring vs Offshoring: Guida Rapida alla Decisione

Recommendation: Il nearshoring vince quando velocità di commercializzazione, consenso del pubblico e salute delle scorte sono prioritari; l'offshoring vince quando domina il vantaggio di costo in località distanti e si tollerano tempi di consegna più lunghi.

Definizione: Il nearshoring colloca la produzione in un breve raggio geografico dai clienti; l'offshoring delocalizza le funzioni in regioni distanti per ridurre i costi.

Parametri di confronto: metriche importanti includono il costo per unità, i tempi di consegna, lo stato delle scorte, il rischio normativo, la volatilità valutaria, la disponibilità di talenti, la protezione della proprietà intellettuale, l'allineamento del fuso orario, il controllo qualità, la preparazione dei fornitori.

Piano d'azione: raccogliere rapidamente i dati; leggere i report di mercato; definire gli obiettivi; misurare i requisiti; stabilire le soglie di fallimento; assicurarsi il consenso degli stakeholder del pubblico; determinare il mix ottimale utilizzando parametri definiti.

Misure di sicurezza pratiche: allinearsi con le aspettative del cliente; misurare i tempi di risposta; disponibilità delle scorte; livelli di servizio; una sede più vicina migliora lo stato delle scorte; le scienze della logistica supportano la valutazione del rischio; mantenere i parametri trasparenti; i possibili risultati includono tempi di risposta migliorati; i risultati aiutano il pubblico a monitorare gli obiettivi.

Note: questa struttura decisionale preserva la flessibilità; rimane rilevante quando le condizioni di mercato cambiano; impegnarsi a rispettare una serie definita di requisiti; le metriche guidano le revisioni trimestrali per mantenere allineate le metriche relative alla salute del cliente.

AI, Analisi Dati e Digital Twin per la Previsione della Domanda

Iniziando con un progetto pilota di 12 settimane che implementa la previsione della domanda basata sull'IA tramite digital twin, utilizzare sensori e integrazioni in tempo reale per affrontare la variabilità, rispondere a domande critiche attraverso la rete di distribuzione e responsabilizzare gli stakeholder che cercano decisioni più rapide. Aspettatevi guadagni in termini di accuratezza delle previsioni del 15–25% e riduzioni delle rotture di stock del 5–15%, con possibili vantaggi con il miglioramento della qualità dei dati. Iniziate con una singola famiglia di prodotti ed espandete incrementalmente, monitorando le milestone man mano che i task vengono completati. Iniziare in piccolo aiuta a garantire che il percorso verso un'implementazione più ampia rimanga gestibile.

Data foundation: connetti i dati di pianificazione principali, i feed POS, i calendari dei fornitori e i record di spedizione tramite un layer di integrazione leggero. Utilizza sensori per segnali in tempo reale e alimenta i digital twin che simulano la domanda e il rifornimento in diversi scenari. Tra i punti di distribuzione, il modello stima i livelli di servizio e le posizioni di inventario, consentendo una rapida analisi what-if e aggiustamenti proattivi che prevengono la deriva e il disallineamento.

Approccio analitico: utilizzo di aggiornamenti bayesiani, modelli di serie temporali ensemble e scenari probabilistici per generare intervalli di previsione. I digital twin vengono eseguiti in parallelo e aggiornati man mano che arrivano nuovi dati dai sensori, alla ricerca di miglioramenti su cui le parti interessate possono agire. Il risultato è un allineamento più stretto e decisioni più rapide e basate sui dati, che aiutano le aziende a definire le aspettative e a rispondere rapidamente.

Allineamento organizzativo e governance

Definire un'iniziativa con sponsorizzazioni interfunzionali; definire i responsabili e affrontare la qualità, la privacy e la sicurezza dei dati. L'integrazione tra gli stack tecnologici dovrebbe seguire standard e best practice; Acharya osserva che l'allineamento tra i reparti è come guidare un cavallo lungo un sentiero stretto, sottolineando passaggi semplici e ripetibili e vittorie visibili. Il punto di partenza è un modello minimo praticabile e il team può affrontare le lezioni apprese, migliorare il piano in modo iterativo e garantire che le attività vengano svolte nei tempi previsti. Ciò potrebbe richiedere cambiamenti culturali, ma il vantaggio è utile per le organizzazioni che cercano segnali di domanda affidabili e un miglioramento delle prestazioni dell'inventario.

ESG, Compliance e Monitoraggio del Rischio dei Fornitori

Raccomandazione: implementare un unico framework di monitoraggio ESG, conformità, rischio fornitori che aggreghi i flussi di dati da procurement, finanza, sostenibilità, QA; configurare analytics per assegnare punteggi di rischio; produrre un report completo per i manager; iniziare con piccoli progetti tecnici; applicare flussi di lavoro agile per accelerare la risposta; fare affidamento sull'esperienza pregressa per calibrare le soglie. Questo approccio probabilmente accorcia i cicli comprimendo i loop di feedback.

Analizzando i dati attuali, queste misure offrono ai manager visibilità su ogni livello della base fornitori; le visualizzazioni basate sull'analisi creano un'esperienza concisa; i flussi rivelano eventi negativi, problemi, deriva della conformità; forse esaminare più frequentemente le categorie di spesa elevata evidenzia le opportunità; un'oncia di prevenzione salva il budget riducendo i costi di riparazione. Questo può diventare una soluzione scalabile.

Measurement framework

I componenti chiave includono la provenienza dei dati; definizione di soglie; avvisi; flussi di lavoro di rimedio; dati sufficientemente granulari tra fornitori, categorie, aree geografiche; segnali azionabili che attivano risposte, azioni; procedure di escalation; questi passaggi riducono il rischio di errore, aumentano la resilienza, supportano il miglioramento continuo; una proprietà chiaramente definita migliora la responsabilità.

| Fonte | Azione | KPI |

|---|---|---|

| Rating ESG | Aggrega, normalizza, avvisa | punteggio di rischio 0–100 |

| Incidenti di conformità | analisi della causa principale, monitoraggio della correzione | giorni medi di chiusura |

| Salute finanziaria | monitoraggio continuo, segnali di rischio di credito | DSCR, giorni di dilazione dei pagamenti |

| Rischio operativo | segnali predittivi, avvisi di interruzione | tempo medio di ripristino |

Don’t Miss Tomorrow’s Supply Chain News – Key Updates and Trends">

Don’t Miss Tomorrow’s Supply Chain News – Key Updates and Trends">