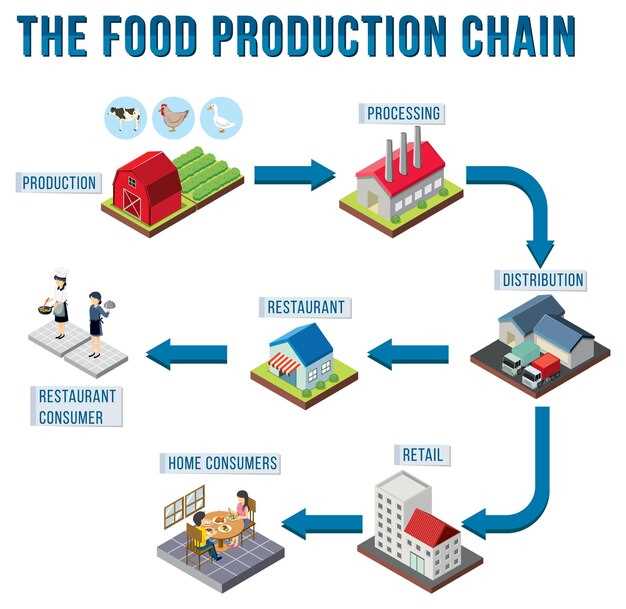

Begin by implementing traceable data layer across partners to maximize nutrition integrity, minimizing spoilage, and secure reliable destination for goods.

Integration stöd real-time tracing from produktion to consumer, aligning with gfsi measures and industry standards.

Developers focus on purpose-built data models, being mindful of provenance and addition of verifiable records, enabling nutrition claims with real-time confidence. That power really translates into reducing fraud and building trust across a formidable industry.

Talking governance frameworks prioritize minimizing data exposure while maintaining audit trails, aligning with gfsi, consumer expectations, and regulatory measures.

4 Discussion Topics on Blockchain-Driven Food Provenance and Operations

Topic 1: Construct four levels of provenance using distributed ledger tech to capture origin, processing, packaging, and distribution milestones; this approach yields verified histories and supports certificate issuance at each stage. Creators and retailers gain trust as google-based queries surface trusted data; previously confirmed records provide bank-grade integrity across chains, enabling seamless document generation and automatic checks for necessary compliance. Years of practice show relevance across markets, and author and creators must align on data standards to keep future benefits consistent.

Topic 2: Automate document flows to enable rapid, verified integrity checks across legos-like blocks of activity from farms to retailers; this reduces back-and-forth, accelerates QA, and cuts error rates. Certificate issuance can trigger automatic checks when data meets certain standards. Cross-functional teams can tag changes with author and creator IDs, while google-style indexing supports quick traceability.

Topic 3: Evaluate effectiveness by tracking time-to-verify, error rates, and cycle time across chains of custody spanning producers, packers, shippers, and retailers. Over years, this data-driven approach yields consistent reductions in waste and recalls. Intended metrics include cost per unit, return rates, and customer trust. Difficult contexts like diverse regulatory regimes demand interoperable records and standardized certificates.

Topic 4: Governance design engages author and creators alongside retailers, auditors, and regulators; set identical access levels, responsibilities, and data-retention policies to keep same standards across jurisdictions. Bank-grade controls plus a conceptual risk framework ensures compliance across markets. Future work should align with industry groups and standards bodies; previously established norms provide relevance for implementation. Automated auditing routines and modular legos-constructed workflows ensure compliance and scalability, while open channels support fast adaptation.

End-to-End Traceability with Blockchain and IoT

Recommendation: Implement a sensor-linked, batch-level logging scheme using a trusted ledger to capture every event from origin to retailer, ensuring data cannot be altered without detection and maintaining calibration records for safety-related steps.

Begin with a minimal viable architecture: attach RFID or QR to each pallet, deploy temperature and humidity probes, use GPS for movement, and push data to edge gateways that perform initial checks before honest compilation into ledger entries.

Results from pilot programs show that linking sensor data with certificate metadata reduces misrepresentation risk, improves recall readiness, and elevates customer trust. In covid-19 era analyses, immediate visibility lowered lost stock incidents by 20–35% in tested routes.

Degree of improvement depends on data quality; key factors include device calibration, time synchronization, and data compilation frequency. Achieved results rely on consistent 3–5 seconds for append operations at gateway, with tamper-evident seals for packaging events.

In practice, never rely on a single source; neither supplier nor facility should host all records. Create a distributed set of collectors and verifiers, enabling safety-related checks such as temperature excursions, humidity, and structural integrity. This collection supports market-facing reporting, allowing customers to view lineage, risk flags, and compliance status.

Experience from cases where covid-19 disrupted flows reveals that eliminating data gaps and mislabeling saves time during crises. A well-structured linkage system enables quick investigation into why a batch failed, facilitating targeted corrections rather than broad recalls.

Examples from tian-region networks show measurable benefits: 40–50% reduction in mislabeling, faster response times, and clearer experience for retailers, brokers, and consumers.

Data flow steps: capture > verify > compile > publish; each step adds degree of assurance. If data being collected lacks verifiable origin, risk of misrepresentation increases; thus, designers must embed digital signatures and non-repudiation into event records. In practice, creators of packaging labels must sign certificates to prevent spoofing.

Shown metrics from pilots include 28–44% faster response times, 15–30% lower loss due to damage, and higher confidence among customers.

This approach helps reshape risk management, eliminating data silos, and enabling continuous improvement across market segments.

Automating Recall Procedures via Smart Contracts

Implement automatic recall triggers via self-enforcing agreements linking batch IDs to current state events and transport updates; contracts enforce hold commands across partner networks immediately.

Powerful recall orchestration reduces risk of escalating illnesses.

In essence, centralized, yet interoperable model accelerates containment, reducing losses pronounced when illnesses spread and product touches multiple nodes.

Utvärderade resultat från flera piloter bekräftar empiriska vinster: snabbare isolering, transparenta källor och minskade förluster, samtidigt som dataintegriteten bibehålls.

Genom att använda engångsvärden förhindras uppspelning och stöd för revision; dataströmmar från ursprungsplats till distributionsnoder flödar med minimal friktion.

Tillhandahållna dataflöden från ERP, kvalitetslaboratorier och transportsensorer driver beslutspunkter; strategier inkluderar återkallelseutlösare, spärrmeddelanden och leverantörsaviseringar.

Denna metod omfattar även leverantörer, bearbetningsföretag och återförsäljare, vilket ger insyn i nuläget och dynamisk riskbedömning.

Kontaktpunkten för utvärdering vilar på egenskaper som spårbarhet, svarstid och inneslutningsnoggrannhet. Bedömda resultat, aktuellt levererat värde och empiriska fynd vägleder den pågående finjusteringen av strategier.

| Step | Data Source | Trigger | Åtgärd | KPI |

|---|---|---|---|---|

| Intagning | ERP, LIMS, WMS | tillståndsändring | lagra händelse, beräkna engångskod | latens, noggrannhet |

| Assessment | sensorströmmar | sjukdomssignal | flagga batch, meddela parterna | återkallningshastighet |

| Execution | kontraktledger | bedömd risk | hållningsfråga, varna källor | minskning av förlorade föremål |

| Efter återkallelsen | granskningsloggar | completion | dokumentation spårbarhet | efterlevnadsgrad |

Ursprungsdatanormer för transparens från gård till bord

Anta tvärdomänstandarder för proveniensdata som anpassar källattribuering, händelsekodning och granskningsbara register i alla skeden, med stöd av en publicerad policy som erbjuder tydlighet för deltagare.

Definiera ett kanoniskt språk för händelsekodning för att möjliggöra samverkan mellan databaser och en webbplats, med tydligt dokumenterade scheman och en referensimplementationssvit.

Sedan datastandarder uppstod har uppmärksammade fall demonstrerat värdet av interoperabel publicering av provenienshändelser mellan jordbruks-, bearbetnings- och detaljhandelsnoder. Viktig metodologisk vägledning från bouzdine-chameeva och treiblmaier informerar praktiska regler för publicering av proveniensdata, lagringspolicy och åtkomstkontroll, vilket möjliggör riskreducering och ansvarsskyldighet.

Policyn bör specificera ett kanoniskt språk för händelsekodning, tillhandahålla referensimplementeringar i flera språk, publicera dessa artefakter på en central webbplats och definiera publiceringsmekanismer för att minimera tolkningsgap och datafeljustering.

Slutligen, bygg upp en intelligensdriven verifiering, minskning av fel och automatisering via robotteknik vid ursprungspunkter för att stärka förmågan till källvalidering och manipulationsskydd, samtidigt som revisionsspår stöds.

Realtidsövervakning av kylkedjan på en delad liggare

Distribuera IoT-sensorer över varje lopp och mata in värden i en delad liggare med automatiskt genererade bevis; konfigurera sömlös inmatning, tidsstämplade händelser och tröskelvärdesvarningar för att kunna svara inom några minuter.

Denna installation adresserar en central utmaning: dataintegritet mellan flera aktörer. Använd en behörighetsmekanism med rollbaserad åtkomst, kryptografiska signaturer och konsensuskontroller för att motverka manipulering och minska sårbarhet. Betrodda deltagare autosignerar värme- eller köldstressvarningar, vilket skapar ett granskningsbart spår som avskräcker bedrägeri och bevarar rykte.

Beräknade förbättringar inkluderar 15–25 % minskat avfall från temperaturexkursioner, 30–40 % snabbare återkallelser och bättre resultat för kunder med verifierbart ursprung. Framsteg inom sensorprecision, datanormalisering och interoperabilitet mellan partners minskar komplexiteten när data flödar från källa till slutanvändare med minimal latens, vilket möjliggör smidig beslutsfattande. Smäckra instrumentpaneler omvandlar mätvärden till användbara insikter.

Tänk dig ett scenario där en enda avvikelse utlöser automatiska arbetsflöden för spärr och inspektion. Om en sensor rapporterar förhållanden utanför intervallet, sätts försändelser i karantän och ruttningen justeras, nedströmspartners får tillförlitliga varningar och manipuleringssäkra loggar tillhandahåller bevis som visar tidigare dolda sårbarheter som åtgärdats och resultat som bekräftats.

För att börja, genomför en kontrollerad pilot i utvalda korridorer med 3–5 partners; definiera dataschemat och en integritetsfokuserad delningsregel; välj en betrodd leverantör med tydlig säkerhetspolicy; övervaka signalerade händelser och iterera på datakvaliteten. Fokusera på att minska sårbarheten, såsom sensorernas kalibreringsdrift, enhetsbortfall och manuell datainmatning, genom att etablera snabb incidenthantering och kontinuerliga förbättringar. Detta flyttar fokus från traditionella kontroller till sådant som tidigare orsakade förseningar. Detta tillvägagångssätt medför mätbara fördelar.

Gränsöverskridande interoperabilitet mellan leverantörer och återförsäljare

Inför gränsöverskridande datautbyte med blockchain-gs1 för att möjliggöra realtidsinsyn hos distributörer och återförsäljare. Denna förändring ger omfattande transparens, minskar fragmenterade informationssilos och främjar sammanhängande samarbete mellan inblandade parter. Detta tillvägagångssätt ger verkliga fördelar i snabbhet och precision.

Definiera vanliga dataelement genom att använda GS1 standardiserar identifierare, batchnummer, utgångsdatum och platsändelser över gränserna. Para ihop data med tidsstämplar för händelser för att stödja korrekta återkallelser och snabba svar på butiksnivå. Effektiv databearbetning genom strömmande validering minskar latensen.

Integrera distributörer, återförsäljare, transportörer och tillsynsmyndigheter som deltagare med rollbaserad åtkomst till information, vilket möjliggör betrodd delning utan att exponera känsliga detaljer.

Frånvaro av interoperabla data åtgärdas genom att etablera ett delat datalager som möjliggör sammanhängande frågor, automatiserad undantagshantering och mer pålitlig prestanda över marknader. Att åtgärda frånvaro genom ett standardbaserat tillvägagångssätt säkerställer skalbarhet.

Skydda känsliga uppgifter genom behörighetsstyrd åtkomst, kryptering och oföränderliga loggar; bevis från piloter visar på förbättrad incidenthantering, spårbarhet och ansvarighet. Insikter från fälttester hjälper till att skräddarsy åtkomstmodeller och datavyer efter regionala behov.

Framväxten av gränsöverskridande standarder minskar behovet av manuella kontroller och snabbar upp introduktionen av nya partner. Implementera detta ramverk med hjälp av en trestegsmodell: upprättande av styrning, pilotprojekt med utvalda partner, uppskalning. Övervaka nyckelindikatorer som ledtid, felfrekvens och kostnad per enhet för att verifiera effektivitetsvinster och motivera bredare användning.

Evidensbaserade rekommendationer för policyanpassning: anta integritetsbevarande datadelning, säkerställ konsumentinriktade skyddsåtgärder och publicera standardiserade nyckeltal. Hållbara vinster kräver styrning som anpassar incitamenten. Bedriv en hållbar verksamhet i korridorer som drivs av innovativa, interoperabla system för att möta långsiktiga behov.

Varje artikelrörelse lagras som en kedja av händelser i blockchain-gs1, vilket gör att butikschefer kan verifiera produktens ursprung och status i alla skeden.

Dataintegritet, regelefterlevnad och granskningsbarhet i blockkedjebaserade livsmedelssystem

Recommendation: Implement privacy-preserving data sharing with consent-driven access, off-ledger storage for sensitive records, and immutable audit trails on distributed ledger; these measures allow verification while keeping data protected.

- Privacy architecture: adopt zero-knowledge proofs to validate attributes without exposing sensitive details; pseudonymize identities; minimize data collected; capture consent with tamper-proof logs; dashboards provide shiny visuals showing permissions, status, and related activity across days and situations; this approach boosts dependability and protects consumers; studies show risk drops when safety-related data stays shielded during production and distribution.

- Compliance mapping: align with GDPR, CCPA, and sector-specific guidelines; define clear data subject rights workflows; implement automated policy checks; maintain evidence trails that demonstrate adherence for regulators; karen from compliance notes best practices in cross-border flows; current practices show smoother audits in days of continuous monitoring.

- Auditability and verification: store tamper-evident, immutable logs; generate automated reports for internal teams and external auditors; offer consumer-facing transparency portals that reveal verified attributes without exposing details; conversely, failure to separate data raises risk; emphasizes secure interfaces and controlled data sharing; production teams access necessary information via role-based views while humans review flagged anomalies.

- People, processes, and risk management: assign data stewards across disciplines; implement privacy, security, compliance training; apply transformation of data handling into measured, auditable steps; ongoing studies show best results when humans remain involved in decision points; currently, risk review cycles run simultaneously with production checks; karen’s case highlights importance of routine audits and clear escalation paths.

In interviews, karen notes positive reception from frontline staff when privacy controls appear in daily operations.

Hur Blockchain Revolutionerar Livsmedelskedjan">

Hur Blockchain Revolutionerar Livsmedelskedjan">